AI Act - nierówny wyścig prawa z technologią

W odpowiedzi na boom AI, Parlament Europejski w przyśpieszył przeprocesowanie regulacji mających mitygować ryzyka związane z rozwojem sztucznej inteligencji. Jest to pierwsza na świecie (wyprzedzamy USA) próba stworzenia prawa, które nadąży za światem technologii. Jak te przepisy wpłyną na rozwój i zastosowanie AI? Czy narzędzia takie jak chatGPT są zgodne z przepisami rozporządzenia? Czy AI Act wprowadzi mądre rozwiązania i czy będzie godną naśladowania inspiracją dla innych systemów prawa? Przyjrzyjmy się temu bliżej.

Europa na prowadzeniu…ale tylko w paragrafach

Mimo, że Chiny i USA w rozwoju technologii są prymusami, UE próbuje wdrożyć standardy, które pogodzą troskę o prywatność i bezpieczeństwo użytkowników z potrzebą przestrzeni regulacyjnej dla dalszych innowacji.

AI Act jest szeroko komentowany, a większość debaty zmierza do konkluzji, że Europa nie będzie globalnym liderem w zakresie regulacji AI, lecz hamulcowym, który jeszcze bardziej pogłębi swoje zacofanie. Innymi słowy, wprowadzimy restrykcyjne prawo (możliwe są grzywny w wysokości 20 000 000 € lub 4% światowego przychodu), a pionierzy przeniosą się do innych jurysdykcji. Jest to główny zarzut, ale nie jedyny, bo przeciwnicy AI Act argumentują, że na tym etapie rozwoju AI nie wiadomo jeszcze dokładnie co trzeba uregulować.

Po co więc te paragrafy?

AI Act rozpoznaje kluczowe obszary, w których technologia przyczynia się do wzrostu gospodarki i komfortu społeczeństwa, ale skupia się na identyfikacji zagrożeń. Unijny prawodawca dostrzega tak naprawdę jeden problem: AI jest tak wszechstronna, że wsiąknie w życie społeczeństw jak w gąbkę. Na codzień chętnie i raczej beztrosko korzystamy z narzędzi, które ułatwiają nam życie. Nie myślimy, jakie zagrożenia wynikają z przetwarzania informacji o nas w big data, jakie problemy będzie rodziło poruszanie się po inteligentnym mieście albo stosowanie zaawansowanej AI w opiece zdrowotnej. Dopóki ktoś nie rozpowszechni deepfake’a z naszym wizerunkiem albo autonomiczny system bojowy nie zastrzeli nam sąsiada - jesteśmy OK z technologią. Warto przeczytać np. książkę „Sztuczna inteligencja 2041” Kai-Fu Lee (były dyrektor Microsoft Research Asia oraz prezes Google China) lub posłuchać [podcastu] z jego udziałem, aby zrozumieć, że potrzeba regulacji obszaru AI jest realna. W AI Act chodzi zasadniczo o stworzenie pola na wyjaśnienie szkodliwych zdarzeń związanych z użytkowaniem technologii oraz rozstrzyganie kto lub co jest odpowiedzialne za dane zdarzenie.

Risk-based approach w AI Act

AI Act jest na końcowym etapie legislacyjnym, więc mamy do dyspozycji niemal ostateczny kształt regulacji. Można się spodziewać, że większość zmian będzie kosmetyczna, a czołowe zapisy pozostaną nietknięte. Opierają się one na analizie ryzyka (risk-based approach) i wprowadzają rozróżnienie między systemami AI, które stwarzają:

Minimalne ryzyko: tutaj wpada większość systemów SI stosowana dotąd w UE, są to bardzo podstawowe systemy takie jak gry wideo z obsługą AI lub filtry spamu

Ograniczone ryzyko: odnosi się np. do chatbotów i wirtualnych asystentów, które mogą wprowadzać w błąd, że mamy do czynienia z człowiekiem

Wysokie ryzyko: system AI wpada w tę kategorię, gdy stwarza poważne ryzyko powstania szkody dla zdrowia i bezpieczeństwa oraz praw podstawowych, czyli:

- prawo do godności człowieka,

- poszanowanie życia prywatnego i rodzinnego,

- ochrona danych osobowych,

- wolność wypowiedzi i informacji,

- wolność zgromadzania się i stowarzyszania się oraz niedyskryminacja,

- prawo do edukacji,

- ochrona konsumentów,

- prawa pracownicze,

- prawa osób z niepełnosprawnościami,

- równość płci,

- prawa własności intelektualnej,

- prawo do skutecznego środka prawnego i dostępu do bezstronnego sądu, prawo do obrony i domniemania niewinności,

- prawo do dobrej administracji,

- ochronę dzieci,

- ochronę środowiska.

Przykładem może być np. zastosowanie sztucznej inteligencji w chirurgii wspomaganej robotycznie albo oprogramowanie do sortowania CV w procedurach rekrutacyjnych. Pierwsze może naruszyć zdrowie, a drugie dyskryminować.

Powyższe przykłady wskazują, że olbrzymia liczba rozwiązań wpadnie w koszyk z etykietą wysokiego ryzyka, co zobowiąże ich dostawców do rozszerzonego compliance. Komisja Europejska określi kryteria umożliwiające przedsiębiorstwom ocenę, czy ich system stwarza wysokie ryzyko. Dostawcy oprogramowania będą zobowiązani przekładać powiadomienia do organów krajowych przed wprowadzeniem systemu do obrotu (z prawem do odwołania), a organy krajowe do przedkładania Urzędowi ds. Sztucznej Inteligencji rocznych sprawozdań zawierających szczegółowe informacje na temat otrzymanych powiadomień i podjętych decyzji. Monitoring przez krajowe organy nadzorcze rozciągnie się również na czas, gdy produkt będzie w obrocie. Oznacza to, że - podobnie jak z RODO - firmy będą na bieżąco raportować np. o incydentach i nieprawidłowym działaniu oprogramowania.

Niedopuszczalne ryzyko: np.: - predykcyjne aplikacje policyjne („predictive policing”), narzędzia biometryczne do analizy emocji w czasie rzeczywistym, social scoring - będą zakazane.

Wszystkie dopuszczone na rynek systemy AI będą musiały spełniać zasadę przejrzystości, co np. dla chatu GPT oznacza:

- informowanie, że treść została wygenerowana przez sztuczną inteligencję,

- projektowanie modelu w taki sposób, aby uniemożliwić mu generowanie nielegalnych treści,

- publikowanie podsumowań danych chronionych prawem autorskim wykorzystywanych do szkolenia modelu

Jak rozporządzenie wpłynie na działalność firm?

Podobnie jak RODO, AI Act wpłynie na organizację pracy nad narzędziami AI.

Zmiana nastąpi przede wszystkim w obszarach:

- zarządzania danymi

Firmy będą musiały sformułować odpowiednie zasady zarządzania dla zestawów danych używanych w szkoleniu AI. Dotyczy to projektowania zbiorów danych, gromadzenia danych, przygotowania danych (czyszczenie, wzbogacanie, etykietowanie) i jakości danych, zwłaszcza w odniesieniu do potencjalnej stronniczości. To formalne zarządzanie danymi będzie wyzwaniem organizacyjnym.

- testów

Firmy rozwijające narzędzia AI będą musiały stosować odpowiednie procedury testowe: oparte na podziale na treningi i testy, ze sformalizowanymi metrykami i progami, aby zapewnić, że rozwiązania AI osiągną zamierzony cel i zgodność z najlepszymi praktykami..

- zarządzanie ryzykiem

Potrzebne będzie wdrożenie i utrzymanie systemu zarządzania ryzykiem, który pozwoli na iteracyjną identyfikację i przewidywanie potencjalnych zagrożeń, które mogą wynikać zarówno z zamierzonego użycia, jak i niewłaściwego użycia narzędzia AI. Dla firmy, w tym startupów dopiero rozpoczynających pracę ze sztuczną inteligencją może to być problematyczne, ponieważ tworzenie i korzystanie z dobrych ram ryzyka wymaga dojrzałości, podczas gdy niedojrzałe ramy ryzyka mogą być nieskuteczne, a nawet tłumić rozwój i innowacje.

- zaostrzone monitorowanie produktu

Poza wymogami w fazie tworzenia systemów AI, AI Act zmusza dostawców oprogramowania do wdrożenia monitorowania produktu po wprowadzeniu na rynek, zgodnie z charakterem technologii i ryzykiem związanym z ich systemem. Innymi słowy, dostawca ma obowiązek oceniać bieżącą zgodność z przepisami.

Koniec końców, wszystkie powyższe obowiązki skumulują się w gromadzenie rozległej dokumentacji.

Czy OpenAI poradziłoby sobie dziś z wymaganiami AI Act?

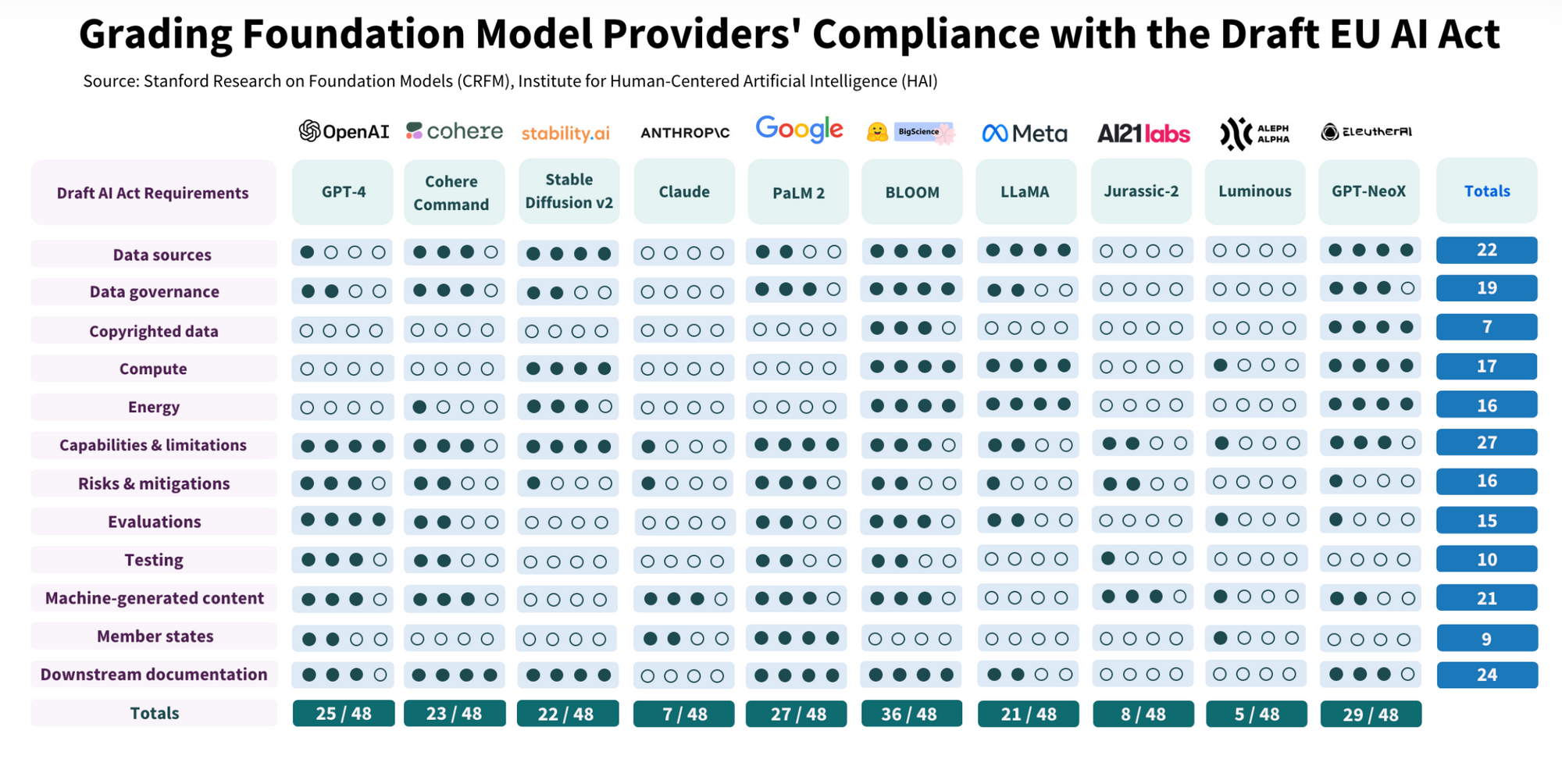

Naukowcy ze Stanforda dokonali [analizy], z której wynika, że większość spośród 10 czołowych modeli AI osiągnęła mniej niż 50% zgodności z wymogami AI Act (w tym GPT-4).

Zachęcam do zapoznania się z podlinkowanymi wynikami badania. Rezultaty researchu wskazują na pewien znaczący trend: otwarte modele generalnie przewyższały zamknięte modele w kilku kluczowych obszarach, w tym przejrzystości źródeł danych i wykorzystania zasobów. Z drugiej strony, zamknięte modele wyróżniały się w obszarach takich jak kompleksowa dokumentacja i łagodzenie ryzyka.

Sztuczna inteligencja godna zaufania?

Postulaty i poprawki przyjęte przez PE 14 czerwca 2023 r. są obszerne, ale podsumować je można jednym zdaniem: UE chce godnej zaufania sztucznej inteligencji. W mojej ocenie niekoniecznie jest to możliwe, ale sama regulacja pozytywnie wpłynie na wypracowanie standardów branżowych, które zwiększą przejrzystość działania systemów AI wobec użytkowników. A to już krok w dobrym kierunku.